app推广aso优化服务

1、就是利用AppStore搜索规则和排名规则,让App更容易被用户搜索或者看到的推广方法,通常我们所说的ASO,指的就是关键词的排名优化。ASO是应用商店搜索优化”的简称;指的是各应用市场提升App在排行榜和搜索结果排名的过程。

2、优化方法大致分为:基础优化、进阶优化、高阶优化三个阶段。选好关键词之后,将热度高的词语排在前面,里面不要重复。

3、App推广方法应用程序商店优化(ASO)在您发布应用程序时,您可以在应用程序商店中寻找ASO优化的方法。ASO优化包括应用程序标题、元数据、应用程序截图等细节。ASO可以提高应用程序在应用程序商店中排名。

4、ASO全称AppStoreOptimization,字面意思可以翻译为「应用商店优化」。延伸说明:一般来说,ASO可帮助开发者提升App在应用商店的流量与下载转化率,从而获取更多用户。

使用scrapy爬虫设置了ip代理报错是怎么回事

一些用户在运用Scrapy爬虫时,遇到了即便配置了IP代理,仍然无法成功发送请求的问题。这种情况出现的原因可能是爬虫的使用方法不正确,或者所选用的代理IP质量不佳。

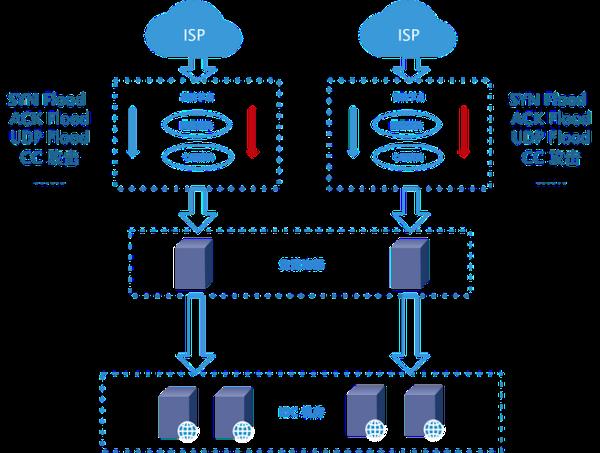

一些网站为了控制流量和防止受到攻击,通常会设置单IP在一分钟内允许的最大请求数。 您在网上找到的利用IP代理来解决IP受限的问题的方法,在大多数情况下确实是有效的。

放慢爬取速度,减少对于目标网站带来的压力,但会减少单位时间类的爬取量。测试出网站设置的限制速度阈值,设置合理的访问速度。

爬数据的时候,有时会遇到被该网站封IP等情况,response的状态码为403,那么这时候我们希望能够抛出 CloseSpider的异常。

对爬虫抓取进行压力控制;可以考虑使用代理的方式访问目标站点。降低抓取频率,时间设置长一些,访问时间采用随机数。频繁切换UserAgent(模拟浏览器访问)。多页面数据,随机访问然后抓取数据。

爬虫代理ip使用方法

爬虫代理ip使用方法如下:使用Python的urllib或requests模块:在Python中,可以使用urllib或requests模块来使用代理IP。

通常,网络爬虫是程序化的接入方式,可以使用API的接入方式直接接入代理IP。网络爬虫想要在最快的时间采集到大批量的信息,要避免防爬技术的拦截问题,就必须要配合使用代理IP。

利用爬虫脚本每天定时爬取代理网站上的ip,写入MongoDB或者其他的数据库中,这张表作为原始表。

在使用爬虫代理池时,我们需要将代理池服务器的API接口集成到我们的网络爬虫中。具体来说,我们需要在网络爬虫中添加以下几个步骤:获取代理IP地址 在访问目标网站之前,我们需要从代理池服务器中获取一个可用的代理IP地址。

以上就是爬虫使用代理ip(爬虫设置代理)的内容,你可能还会喜欢爬虫使用代理ip,爬虫代理ip,代理网站,爬虫代理ip使用方法,ip代理等相关信息。